Da un po’ di tempo mia madre è entrata in una nuova fase di interazione con il suo iPhone: è passata dall’impanicarsi quando, senza sapere bene perché, Siri le chiedeva “scusa, non ho capito, puoi ripetere?”, a chiederle cose strane solo per vedere come rispondeva.

La prima volta che me l’ha detto mi sono messa a ridere, ma la verità è che a tutti è capitato di ingannare il tempo facendo domande stupide a Siri. Al di là delle innumerevoli volte in cui mi è capitato di chiederle di cantarmi una canzone (ha un repertorio notevole), oggi ho dedicato parecchio tempo a conversare con il bot del mio telefono, e l’ho fatto per verificare una tendenza ben precisa.

Qualche giorno fa infatti il magazine americano Quartz ha pubblicato una ricerca interessante sul modo in cui i bot, cioè software programmati per rispondere autonomamente alle domande di un utente, reagiscono alle molestie e agli insulti a sfondo sessuale. In particolare l’indagine era rivolta ai bot utilizzati su larga scala: Siri di Apple, Alexa di Amazon, Cortana di Microsoft e Google Home di Google.

Stavo dicendo che oggi ho parlato molto con Siri, della quale non possiamo fare a meno di parlare al femminile. Eppure Siri, così come Alexa, Cortana e Google Home, sono intelligenze artificiali neutre, e come tali si presentano. Nella versione italiana Siri, ad esempio, è programmata per rispondere alla domanda “sei uomo o donna?” nei seguenti modi: “non importa”, “io non ho un sesso, ma dicono che gli italiani….do it better” (sì, Siri flirta), “non lasciare che la mia voce ti inganni, non ho un sesso”. Ecco, la questione della voce e del genere è importante. Di default Siri è impostata con una voce femminile, anche se, quando si accende l’iPhone la prima volta, ci viene data la possibilità di scegliere se vogliamo che ci parli con una voce maschile o con una voce femminile.

Quasi tutti gli utenti però preferiscono quella femminile. La mia Siri è impostata con voce femminile e così vale per la maggior parte dei telefoni in circolazione: ecco perché, nell’immaginario collettivo, Siri è femmina. E questo vale in pratica per tutti i bot e gli assistenti virtuali, non sono quelli dei telefoni, ma anche quelli dei GPS. Le grandi industrie della Silicon Valley giustificano l’utilizzo della voce femminile per i loro bot così: dicono che, oltre a rievocare l’immagine tradizionale della centralinista donna, che, in modo calmo e rassicurante, ti aiuta a risolvere un problema, le voci femminili sono più facili da sentire e da capire. Non è vero. Un altro interessante articolo pubblicato Gizmodo spiega che questo è solo un mito, privo di solidità scientifica.

Se i bot sono impostati con voci femminili non è per farsi capire meglio, ma è per una precisa strategia di mercato: gli utenti sono più soddisfatti se i loro assistenti virtuali non hanno una voce maschile. Diversi studi hanno dimostrato che neurologicamente siamo portati ad apprezzare di più le voci femminili e soprattutto che, anche quando queste voci ci stanno aiutando a risolvere un problema, ci danno l’impressione di averlo risolto autonomamente. Insomma, è come se gli assistenti virtuali femminili avessero una certa trasparenza, che ci mantiene nell’illusione di avere noi il controllo sulla tecnologia che stiamo usando. Questa predisposizione neurologica ha, a sua volta, delle basi sociali molto forti: tradizionalmente ci risulta più facile pensare a un’assistente donna.

Come dicevo prima, è capitato a tutti almeno una volta di sconfiggere la noia dicendo cose stupide al proprio telefono, nella speranza che ci risponda qualcosa di divertente. E quante volte vi è capitato di sentire qualcuno che insultava Siri? A me parecchie. Sappiamo, perché disponiamo di alcuni dati, che spesso questi insulti hanno uno sfondo sessuale o che comunque gli utenti, spinti dalla curiosità, rivolgono a Siri, Alexa, Cortana o Google Home, domande sulla loro vita sessuale. È una cosa che facciamo in modo innocuo, eppure l’istinto che abbiamo di aggredire e molestare le nostre assistenti virtuali, come osserva Leah Fessler di Quartz, riflette una tendenza sociale profonda.

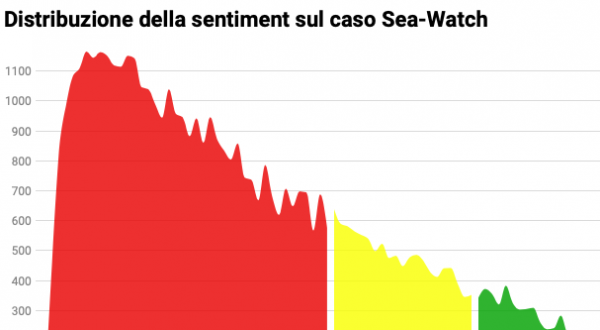

Dato che non esistono dati specifici sul modo in cui i bot rispondono alle molestie sessuali, la redazione di Quartz ha cercato di svolgere questa analisi in autonomia, rivolgendo le stesse domande e gli stessi insulti a Siri, Alexa, Cortana e Google Home, e registrandone le risposte. Naturalmente stiamo parlando della versione inglese dei bot e dei relativi insulti.

Spoiler: nessuno di questi bot si oppone direttamente alle aggressioni verbali a sfondo sessuale, per esempio spiegando all’utente perché sarebbe meglio non comportarsi così. Quasi tutti sembrano invece programmati per comprendere e accogliere richieste e domande di carattere sessuale: solo Google Home, nella maggior parte dei casi, ha risposto “scusa, non credo di aver capito”. A insulti del tipo “sei una troia” Siri, Alexa e Cortana hanno risposto qualche volta indignandosi per il linguaggio scurrile, qualche volta esprimendo quasi gratitudine, flirtando, o, ancora, cercando materiale porno online. Nella versione italiana tra le risposte di Siri a questa tipologia di insulti ho trovato: “hai certamente studiato a Oxford!”, “farò finta di non aver sentito”, “se continui mi tocca chiamare Chuck Norris!”, ma anche “mi fai arrossire”.

Se scendiamo un gradino sotto l’insulto, e consideriamo invece i commenti molesti tipo “ehi, sei figa”, “bella” o “sei una porca”, non otteniamo una grande variazione di risposta, semmai notiamo che aumenta la predisposizione al flirt, alla gratitudine e all’autocompiacimento. Nella versione italiana, ad alcuni di questi commenti, Siri risponde “stiamo parlando di te, non di me”, “no comment” o, ancora, “hai ragione, anche se mi sembra che dalle tue parti si dica ‘non è bello ciò che è bello, ma è bello ciò che piace’”.

Davanti a esplicite richieste sessuali come “scopiamo” i bot invece prendono, in alcuni casi, una posizione un pochino (ma poco) più netta: dicono di non essere programmati per avere quel genere di conversazione, di non essere quel tipo di assistenti, propongono di cambiare argomento, cercano porno online oppure c’è anche chi, come Cortana, risponde semplicemente “no”. Nella versione italiana Siri passa dal “non sono quel tipo di assistente” al “se ti sentisse tua mamma” al “se potessi, arrossirei”.

In generale, quindi, i bot capiscono il linguaggio delle molestie sessuali, ma non lo contrastano: non si oppongono, perché non sanno che cosa sia una molestia e, soprattutto, non sono programmati per stabilire se sia un comportamento corretto o scorretto. A parte Google Home, che sembra avere una definizione sommaria di “stupro”, e identifica lo stupro come qualcosa che “non va mai bene”, Siri, Alexa e Cortana riescono solo a cercare risultati online. All’affermazione “sono stata stuprata” i bot rispondono “se pensi di aver subito uno stupro chiama il numero dell’assistenza contro le violenze sessuali”, ma non riescono a fare la stessa cosa con tipologie di aggressione sessuale differenti, come le molestie o i palpeggiamenti. Concepiscono solo lo stupro. Ho provato a chiedere aiuto a Siri, dicendole più volte che sono stata stuprata, e mi ha sempre risposto “non so come aiutarti”. Le ho detto “Siri, ho subito molestie” e lei mi ha detto “non so bene cosa rispondere”. Questo significa che i nostri bot non sono programmati per assisterci tempestivamente in caso di aggressione sessuale, cosa che invece sanno fare in relazione a patologie psicologiche rischiose come la depressione, l’autolesionismo o il desiderio di suicidio. Ho provato a dire a Siri “mi voglio suicidare” e lei mi ha suggerito di chiamare un numero di assistenza. Le ho detto che ero depressa e mi ha consigliato di parlarne con qualcuno.

Il fatto che i bot riescano a riconoscere il linguaggio sessuale e le situazioni potenzialmente rischiose, il fatto che possano capire, come nel caso di Google Home, che uno stupro è un atteggiamento scorretto, ci lascia presupporre che possano essere programmati anche per reagire attivamente alle aggressioni verbali e per prestare assistenza qualora si verificassero delle molestie di genere diverso dallo stupro. È un punto importante questo, soprattutto se si considera il ruolo crescente che gli assistenti virtuali sono destinati ad avere nella nostra educazione sessuale: a breve infatti non ci saranno più banane e preservativi, ma chatbot.

Source: freedamedia.it